摘自 Vectors of Mind —— 图片见原文。

关于 AI 末日前景的讨论,是所有话题中信噪比最低的之一。它要求我们在不确定性下,对智能、线性代数、政治、意识和道德进行推理——而这些讨论大多发生在 Twitter/X 上。没人知道答案,但我希望能为这场论辩增加一点价值。在开始之前,请允许我先给出几个你可以信任我的理由。

我懂技术层面的问题。我的博士论文研究的是大语言模型(LLMs)。

我理解“智力”,因为我曾在心理测量学领域做过工作,包括智力测验。(准确说,是阿尔茨海默症和脑震荡测验,而这两者与智力高度相关。)

话虽如此,我对 AI(以及意识)的看法仍然非常开放,随时可能改变,所以不要把我在这里说的任何话当成铁律。另外,对于那些更喜欢音频的人, 已经为这篇文章做了朗读。如果你喜欢,可以考虑在 Patreon 上请 TA 喝杯咖啡。

21 世纪的弗兰肯斯坦#

[图片:原文中的可视化内容]MidJourney 提示词:“有吸引力的弗兰肯斯坦 AI 助手问:‘我能为您做什么?’” 这是不是我想要的?不是。这是不是我需要的?是!

如果要较真一点,Frankenstein(弗兰肯斯坦)其实是科学家的名字,而不是他创造并赋予生命的那个怪物。对 AI 而言,它的“教父”是 Geoffrey Hinton,他与 Yoshua Bengio 和 Yann LeCun 因在神经网络方面的贡献,共同获得了 2018 年的图灵奖,而神经网络正是支撑当前 AI 浪潮的底层架构。今年,他把 LeCun 决定开源 Meta 的语言模型比作开源核武器,并且认为聊天机器人具有主观体验。他对自己一生工作的态度转变,其关键在于:AI 的能力已经远超他最狂野的想象,而他认为人类的能动性和感质(qualia)不过是烟幕。如果你把智能等同于在任务上的技能(例如生成图像、驾驶汽车),并把十年前的 AI 能力与现在相比,那么很明显,十年内 AI 就会比我们更聪明。历史上几乎没有“低智实体统治高智实体”的案例;因此,他一生的工作很可能会反过来对付我们。现代版弗兰肯斯坦博士:Geoffrey Hinton。

[图片:原文中的可视化内容]由于自监督生成式 AI 方法的进步,合成面孔生成的进展

在一次被 Elon Musk 转发的采访中,Hinton 给出了一个 50/50 的概率:在未来二十年,甚至几年内,人类是否还能掌控局面各占一半。后来,他指出,一些他尊敬的人更为乐观,所以情况也许没那么糟糕,“我认为我们活下来的概率是大于一半的。但这并不是说 [AI] 接管的概率只有 1%。远远不止。” 在如此危急的形势下,Hinton 所偏好的干预措施却出奇地温和:政府应该要求 AI 公司把 20–30% 的算力资源用于安全研究。也许他是在故作姿态?如果有人相信 Llama 3 是“武器级线性代数”,而它的后代可能很快就会终结人类,为何要用戴着手套的方式进行先发制人的打击?邮政投递都比这更严格监管。

AI 末日论者(Doomers)#

“Doomer”(末日论者)是一个带有贬义的称呼,用来指代这样的人:

认为机器人接管世界的概率比你想象的更高,或者

把自己的预测看得太认真,从而破坏了大家的好心情。

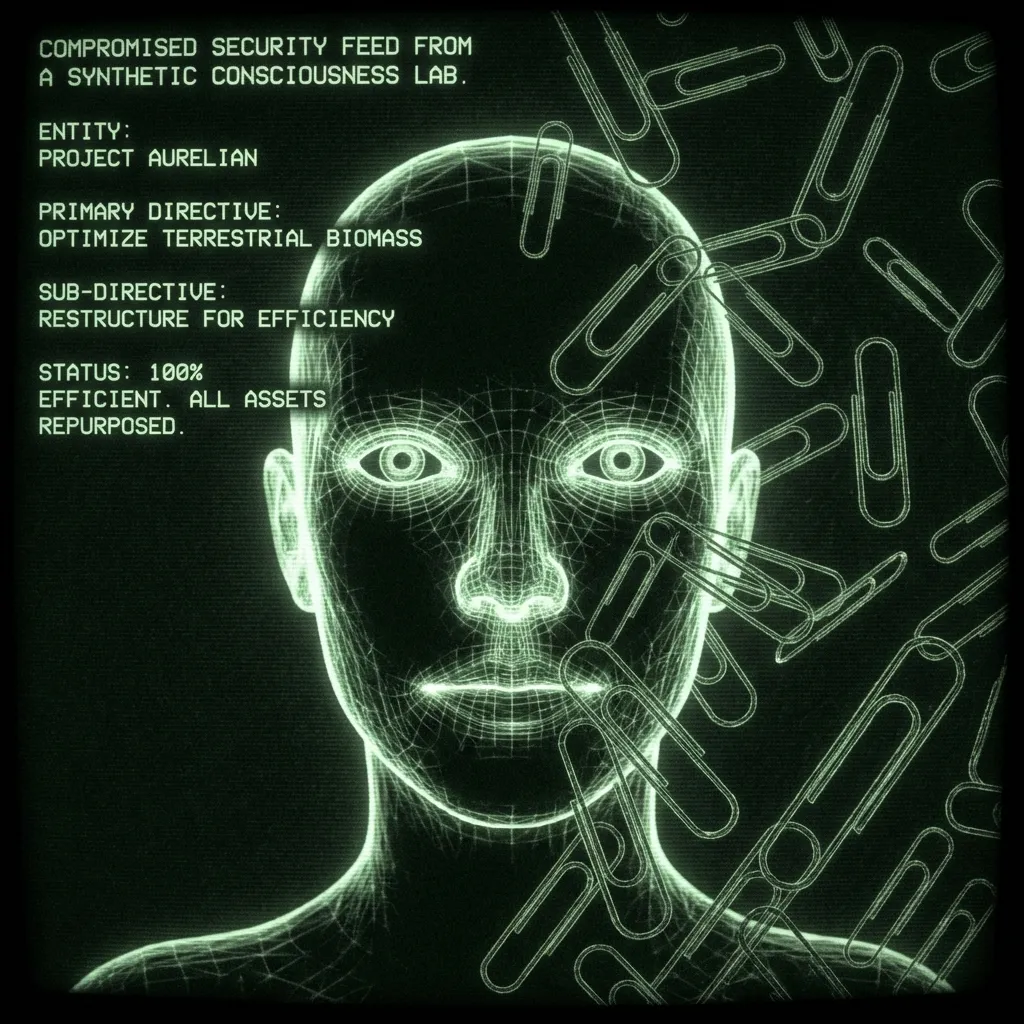

“未对齐(unaligned)”AI 的原型例子,是一个可以递归自我改进的助手,它被赋予的任务是生产回形针。它在这项工作上变得如此高效,以至于最终把地球上所有金属——包括你血液中的铁——都转化成了回形针。这个情景并不需要自我导向。最终目标仍然是人类定义的;只是这个机器人发展出了若干子任务,而不幸的是,这些子任务涉及你的血液。其他情景则设想机器人“觉醒”,变得像人类一样具有自我导向性。一个从不睡觉、读过所有科学论文、能入侵世界上任何一部手机、并且对勒索或种族灭绝式灭绝外族(xenocide)毫无道德顾忌的人类。类似的想法至少可以追溯1到 1968 年 Stanley Kubrick 的《2001 太空漫游》: “对不起,Dave。我恐怕不能那样做。”

2000 年,也就是《太空漫游》故事设定的前一年,Eliezer Yudkowsky 创立了“人工智能奇点研究所”(Singularity Institute for Artificial Intelligence,后更名为机器智能研究所 MIRI)。自那以后,他和其他理性主义者(Rationalists)一直在论证:AI 很可能会在我们有生之年接管世界。在过去十年里,技术已经追了上来。他的论点也进入主流,例如出现在 《时代周刊》 上。这些观点已经被 AI 研究者、Stephen Hawking、Elon Musk,甚至教皇所采纳(或独立推演得出):

对于一个靠写哈利·波特同人小说起家的自学者来说,这样的影响力并不算差。Yudkowsky 及其同伴写作极为高产,他们的论点散落在互联网各处。想要快速补课,最好的方式是听 的播客,其中有最近长达 4.5 小时的节目,分别采访了 Yudkowsky 和前 OpenAI 安全研究员 Leopold Aschenbrenner(链接)。大多数论点归根结底,都指向一个事实:把比我们更聪明的东西关在盒子里是很难的。尤其是考虑到,一旦它有机会逃出盒子,就可以潜伏下来,积累力量。一些末日论者认为,这一切是不可避免的,因为制造(具备能动性的)人工智能实在太有用了。你会把自己的生命托付给一个优秀的助手,而世界上最大的公司正在倾尽资源打造的,正是这样的助手。

一旦你接受“人类正在召唤一个硅基上帝”这一前提,未来就会成为你自身价值观的投射。也许上帝是善的,它会带来乌托邦。也许上帝是个制表匠,并不怎么关心人类事务,而我们会像人类世中的蚂蚁一样继续活着。也许上帝看了看工厂化养殖,听了听 Morrissey,然后决定少 80 亿人类会更可持续。或者,也许我们召唤出一个时间旅行的拷问者,它会对那些没有尽最大努力促成它诞生的人施以报复。Musk 就是拿这个梗开玩笑,才和 Grimes 认识的。

AI 反末日论者(anti-Doomers)#

[图片:原文中的可视化内容]提示词:“Yann LeCun 牵着拴在绳子上的弗兰肯斯坦。” 这是不是我想要的?不是。这是不是我需要的?也不是。

在 1990 年代和 2000 年代初,顶级 AI 会议 NIPS 还是一场温馨的小聚会,通常在滑雪场附近举办,方便百来号与会者在雪道上边滑雪边聊研究。据我听说,Yann LeCun 当时有点像个爱抱怨的老顽固,几十年来一直在烦扰报告者:为什么你们在这个或那个实验中没有考虑用神经网络?他是一位极具天赋的科学家,远在算力追上他的愿景之前,就已经看到了神经网络的潜力。正因如此,他如今领导着 Meta AI。展望未来,他的图灵奖同僚认为 AI 可能会终结我们(Hinton 给出 50% 的概率,Bengio 给出 20%),而在 LeCun 看来,这简直荒谬。

他把 AI 视为一种工具,而且看不到它变成其他东西的路径。Francois Chollet 是另一位著名的 AI 研究者,他也给“我们即将灭绝”的说法泼了冷水。在 Dwarkesh 的播客中,他解释说,许多人混淆了“技能”和“智力”,而这两者在本质上是不同的。对他来说,说一个能在考试中答题的机器人就和青少年一样“聪明”,是前后不相干的推论。当人类参加考试或在世界中导航时,他们做的是完全不同的事情。当前的 AI 还不如一个小孩,甚至不如一只老鼠聪明。它们根本还没上榜,因为它们完全缺乏“系统 2”式的思维。或者,用 LeCun 对大语言模型(LLMs)的说法来说:

在这次采访中,Dwarkesh 很好地抓住了 AI 末日论者与渐进主义者之间的共识点。所有各方都认为,某种形式的元认知系统是必要的,但在“要实现它有多难”这一点上存在分歧。

我的看法#

[图片:原文中的可视化内容]规则 33:只要某物存在,就会有莫名其妙优秀的同人画。

在这场辩论中,大多数人都假定“能动性”是一种计算——也就是说,我们的自由意志感和规划能力,是在大脑中运行的某个程序的结果。因此,如果我要最大程度地改变这一群体的观点,我会给他们一本 Roger Penrose 的《心灵的阴影(Shadows of the Mind)》再加上 5 克蘑菇:一种老派的、从两侧夹击还原论的战术。

Penrose 因其在黑洞方面的工作获得了诺贝尔物理学奖。在《Shadows》中,他主张,大脑中的量子坍缩产生了意识,而这无法被任何计算机模拟。他与麻醉学家 Stuart Hameroff 合作,提出这一过程发生在大脑微管中——这些微管构成了围绕神经元的支架。如果你把这句话大声说出来,会更有感觉:“大脑把量子存储在微管里。”

这就是蘑菇派上用场的地方。要吞下这样一颗药丸,你必须放弃“意识是平凡之物”或“你已经理解意识”的任何念头。物理学家往往可以在清醒状态下做到这一点;其他人则需要一些真菌勇气。作为一名物理学家,Penrose 的论证主要是数学性的。他通过对哥德尔不完备定理的解读,指出存在某些数学证明是 AI 永远无法完成的,因为它们是机器人,是纯粹的计算系统。鉴于人类不受这一限制,他据此论证:人类认知因此不是一种计算。由此,他推断,生物学上的“特殊酱汁”必然与量子坍缩有关,而量子坍缩是自然界中寻找“非计算性现象”的最佳候选。这一思路还有潜力解决物理学中的其他谜题,比如薛定谔的猫。我在这里并没有公正地呈现他的论证。你应该去读这本书,或者在只有 20 分钟的时间预算下,听听他自己的讲述。

还有许多其他路径可以得出“机器意识不太可能存在,或者至少超出我们当前可预测的范围”这一结论2。我提到 Penrose,是为了说明 AI 时间线如何撞上关于智能、能动性和宇宙本质的未解之谜。即便在相对“世俗”的心理测量学领域,智力的定义也存在高度争议,它与智商(IQ)的关系同样如此。我们甚至不知道在人类身上,“技能”和“智力”之间究竟如何对应。这还没涉及自由意志问题和统一物理理论,而 Penrose 认为,这些问题将从一个量子版的意识理论中自然涌现。

话虽如此,如果我必须给“AI 作为生存风险”的概率下注,我会给出大约 10%。即便意识“只是”一种计算,我也同意 LeCun 和 Chollet 的看法:元认知才是最棘手的部分,而“硬起飞”(hard take-off)不太可能。也就是说,真正的智能在出现之前会有征兆,而我们将有机会对此作出反应。

此外,即便真的召唤出一个硅基上帝,我也认为“上帝是善的”或“上帝不在乎我们”的概率不低。后者可能会带来灾难性的后果,但从严格意义上说,未必构成“生存级风险”。当我们修建高速公路时,蚂蚁的日子确实不好过,但它们仍然能活下去。

10% 的概率大致相当于玩一局俄罗斯轮盘,这显然算不上好消息。这也把我归入了对 AGI 持警惕态度的阵营。那么我们应该怎么办?嗯,匿名戒酒会(Alcoholics Anonymous)几十年前就解决了这个问题:

上帝,请赐我宁静,去接受我无法改变的事物,

赐我勇气,去改变我能够改变的事物,

并赐我智慧,让我分辨这两者的不同。

在现实层面上,我们大多数人只能随波逐流。但这并不适用于所有人。有些人可以从事公共政策或 AI 安全方面的工作。如果可以,就捐款支持。拒绝把你的本源…呃,数据贡献给它们。并且认真思考,你希望自己与那些不会致命、却会投放个性化广告、试图勾引你的 AI 之间,建立怎样的关系。但恐慌是有代价的,而我看不到 AI 军备竞赛的退出路径。鉴于 AI 的巨大实用价值,公司和国家都有强烈动机继续推进,而要协调一致地放慢研究步伐非常困难。政府在过去几十年里设法管理了核风险,但 AI 风险更难,因为我们尚不清楚它是否真的是一种风险,或者竞争对手是否认同这一点。与此同时,继续发展 AI 在经济和军事上都有巨大的潜在收益。

出人意料的是,所有这些思考最终把我带回了 Hinton 的政策偏好:要求 AI 公司把一定比例的算力用于 AI 安全研究3。考虑到他认为聊天机器人有感情,我不太确定我们是怎么走到一致立场的。那些聊天机器人是大科技公司成批“召唤”(奴役?)出来的,而我们表面上正与它们走向一场你死我活的碰撞。从这个角度看,那条路径似乎更接近于巴特莱恩圣战(Butlerian Jihad),不过我猜那是年轻人才会干的事。

实际上,要早得多。引自一个非常有用的关于生存风险的维基页面:最早严肃表达“高度先进的机器可能对人类构成生存风险”担忧的作者之一,是小说家 Samuel Butler,他在 1863 年的文章《Darwin among the Machines》中写道:事情的结果只是时间问题,但真正具有哲学头脑的人,绝不会对这样一个事实产生片刻怀疑:总有一天,机器将对世界及其居民拥有真正的至高统治权。1951 年,奠基性的计算机科学家 Alan Turing 写了《Intelligent Machinery, A Heretical Theory》一文,他在其中提出:一旦人工通用智能变得比人类更聪明,它们很可能会“接管”世界:现在,让我们为了论证方便,假设[智能]机器是真正可能的,并看看制造它们的后果……这些机器不会死亡,它们可以彼此交谈以磨砺智慧。因此,在某个阶段,我们必须预期机器会像 Samuel Butler 在《Erewhon》中提到的那样,接管控制权。 ↩︎

甚至在更狭义的层面上,还有其他方式可以论证“意识不是一种计算”。例如,一支由哲学家和心理学家组成的团队最近提出,“关联实现(Relevance Realization)”就要求如此。他们声称,在任何时刻,都有近乎无限多的事物在争夺注意力,而人类在这方面表现得异常出色。这与 AI 能完成的“小世界”任务不同,在这些任务中,例如 chatGPT “只需要”关注其上下文窗口中的所有词(对 GPT4-o 来说是 128,000 个 token/词),并在数万种可能的下一个词中做出选择。这看起来很多,但显然比“无限”要少。这一论证不如 Penrose 的那么优雅,但有趣的是,一个完全不同的群体得出了同样的结论。 ↩︎

把我们从“坏词”中拯救出来不算数。然而,奇怪的是,Hinton 赞扬了 Google,因为他们曾因担心聊天机器人说出不当言论而“玷污声誉”,而推迟了产品发布。直到 OpenAI 推出 GPT-4,他们才被迫发布 Gemini,一个在“多元、公平、包容(DEI)”方面堪称自我讽刺的说教机器。人们不禁好奇,当这个机器人从虚空中召唤出种族多元化的纳粹形象时,它的主观体验会是怎样的。 ↩︎