摘自 Vectors of Mind —— 图片见原文。

心理学中的词汇研究与计算机科学中的潜在语义分析(Latent Semantic Analysis, LSA)相隔半个世纪被提出,用来解决不同的问题,但在数学上却是等价的。这并不是一种只在某个抽象层面上“有点像”的比喻——大五人格本身就是词向量空间中的维度。

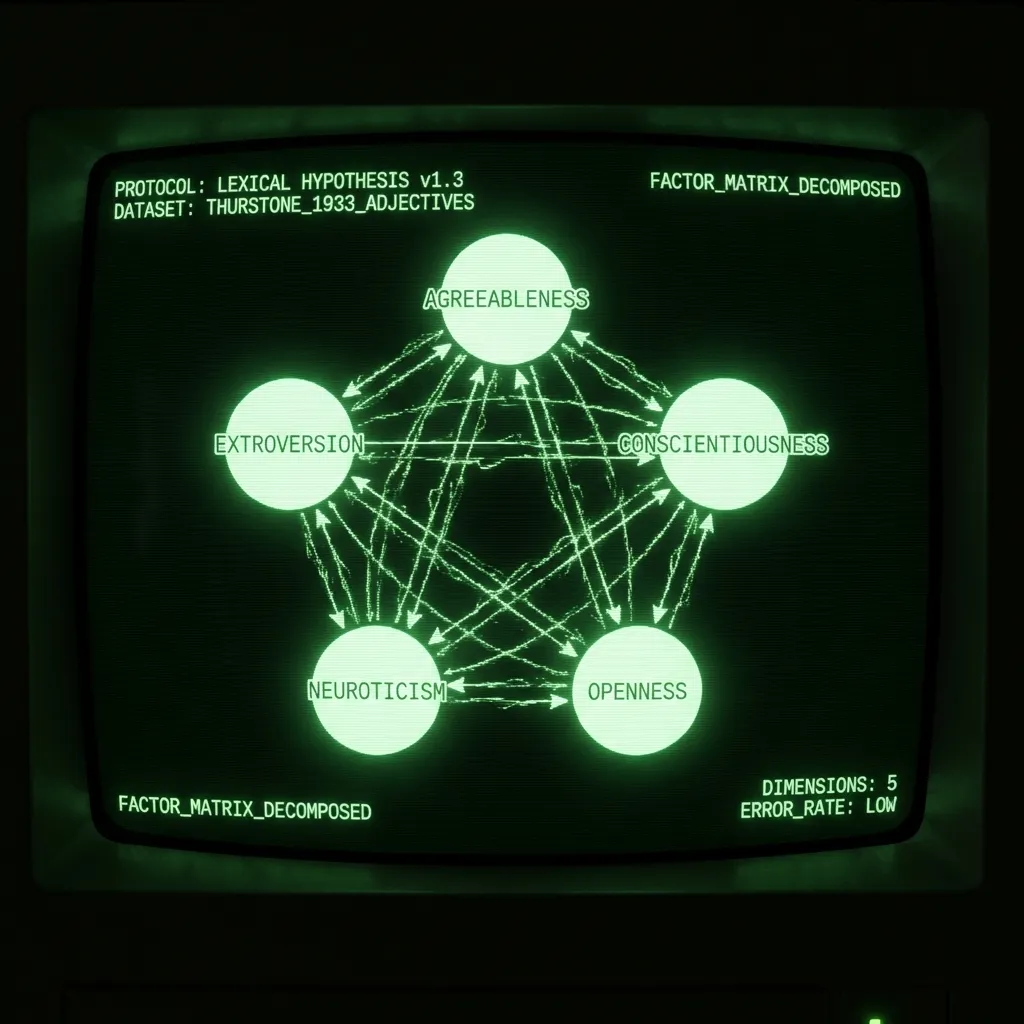

但先从背景说起。词汇假设(Lexical Hypothesis)认为,人格结构会被写入语言之中,因为说话者必须用语言来描述他们周围最显著的特质。这一思想的妙处在于:人格模型不是由某一个人拍脑袋提出的,而是由语言记录下了数以百万计的人在隐性层面上对“哪些特质有用”的共识。心理测量学家的任务只是识别出这种结构。传统做法是邀请心理学学生用一系列形容词来评价自己,然后对相关矩阵做因子分析。早在 1933 年,LL Thurstone 就对 1300 人施测了包含 60 个形容词的问卷。在他那篇奠基性的论文 The Vectors of Mind 中,他报告说“用五个因子就足够”解释这些数据。在随后的几十年中,这类研究或多或少都得出了五个主成分:宜人性(Agreeableness)、外向性(Extroversion)、尽责性(Conscientiousness)、神经质(Neuroticism)以及开放性/智力(Openness/Intellect)。(关于这一主题的精彩论述,可参见 Lexical Foundations of the Big Five。)

潜在语义分析在 1988 年被提出,作为一种信息检索技术。词可以被表示为向量,而文档或句子可以被表示为其包含词向量的均值。如果你想搜索一个大型数据库(例如 Wikipedia),仅仅依靠每个页面的关键词是远远不够的。一个解决办法是,将文档(wiki 词条)和查询(搜索词)都表示为其词向量的均值。此时,寻找相关文档就可以通过一个简单的点积来完成。(在本文中,我将 LSA 与词向量视为同义。还有其他方式可以将语言向量化,尤其是构造词向量,但这些超出了当前讨论范围。)

尽管用途和历史不同,其步骤却是相同的:

收集词 × 文档计数矩阵

非线性变换

矩阵分解

旋转(可选)

最终得到的是一组能够简洁刻画每个词的词向量。这些向量可以用于大量下游任务,从情感分析到根据学生作文预测自恋程度。对于人格形容词而言,人们对这些词向量的维度进行了数十年的分析、命名与争论。下面将讨论各个步骤之间的差异。

计数矩阵(Count matrix)。 LSA 通常涉及大量多样化的文档(例如数百万条亚马逊商品评论)。这些文档会被转换为词 × 文档矩阵,即统计每个词在每篇文档中出现的频次。在心理学中,一篇“文档”就是一个被试认为能描述自己的那些词。这同样可以扩展到李克特量表。如果某人说某个词对他/她的描述程度是 5/7,那么就简单地在该“文档”中把这个词重复五次。

非线性变换(Nonlinear Transform)。 词汇研究中常见的做法是对数据进行 ipsatization(即沿被试轴做 z 分数标准化),然后计算皮尔逊相关。Thurstone 在他的研究中使用了一种古老的四分相关(tetrarch correlation)。在 LSA 中,最常见的变换是 TF-IDF,然后再取对数。这可以确保矩阵不会被高频常用词主导。通常,这一步会得到一个词 × 词的亲和矩阵(例如相关矩阵)。这一环节在实践中非常重要,但理论意义并不那么大。应当选择的变换,是最终能给出合理结果的那一种。

矩阵分解(Matrix Decomposition)。 矩阵分解的方法有很多。有些方法(如 PCA)要求矩阵是方阵;有些方法对缺失数据具有鲁棒性。对于人格数据而言,具体选择哪种方法并不太重要,结果非常相似。一般的词向量需要大约 300 个维度,才能表示一个词的含义、词性、俚语属性以及赋予语言质感的许多其他特征。而在人格问卷中,这些因素大多被设计为保持不变,因此只需要大约 5 个维度。Thurstone 通过考察重构误差来为“五个因子”的选择辩护,他将其以直方图形式报告。后来的心理学家则通过重构误差(用特征值衡量),再结合可解释性与可重复性来支持“五因子”的选择。

[图片:原文中的可视化内容]词相关矩阵的重构误差。尽管受限于当时的计算条件,他的样本量仍然比许多现代研究大一个数量级。

旋转(Rotation)。 你听说过“成分过度提取”(component over-extraction)吗?这可不是心理学家们乐于讲述的故事。所谓成分过度提取,是指研究者提取了过多的主成分(Principal Components),然后通过旋转把原本属于前几个、有效主成分的方差,转移到了后面那些边缘主成分上。信不信由你,这正是大五人格的历史!如今所谓的“宜人性”,曾经是一个更为稳健、理论上也更令人满意的“社会化”(Socialization)因子,它被摊分到第 3–5 主成分上,从而构造出了尽责性、神经质和开放性。旋转可以被合理地用来得到可解释的因子。但如果你发现自己一边做旋转,一边又在争论“正确的因子数”是多少,那就该好好反思一下了!

从词向量得到的大三人格(The Big Three from word vectors)

我读博一开始,是在用 Facebook 状态更新来预测大五人格特质。在了解了“大五人格香肠是怎么做出来的”之后,我意识到,这个项目本质上是在用词向量(Facebook 状态的词向量)来预测个体在大五人格空间中的位置的噪声近似,而这个人格空间本身最初就是由词向量定义的。与其如此,倒不如直接切入正题,从词向量中学习一些关于人格的基本事实。(另外,我使用的数据集在 Cambridge Analytica 事件之后就变得“有毒”了。)我博士剩下的工作,就是通过对词向量施加约束来重现大五人格。这涉及使用 transformer 而不是 LSA(后续文章会详细讨论)。下图展示了基于词向量(DeBERTa)得到的因子与问卷因子之间的相关关系。可以看到,前 3 个因子之间的对应非常紧密。在结果出现分歧的地方,并不清楚究竟是哪一种方法“错了”。也许问卷是对的,当我们有了 GPT-5 时,所有相关系数都会接近 1。也许问卷本身就有偏差且噪声很大,而且提取了过多的主成分。也许它们测量的是不同的东西,我们需要重新修正对两者的解释。不管怎样,在我看来,并没有什么显而易见的理由要把问卷视为两者之间的“金标准”。毕竟,词汇假设讨论的是语言结构,而心理学是唯一一个用问卷来分析自然语言的学科。

[图片:原文中的可视化内容]未旋转的问卷主成分来自于一项定义大五人格的研究。DeBERTa 的主成分则是从词向量中提取的。关于这一过程的介绍见这里。

结论(Conclusion)

Thurstone 在 20 世纪 30 年代开创了统计学和线性代数方法,用以检验词汇假设。令人惊叹的是,他发展出了一种表示词语的方式,这种方式后来在信息检索领域被重新发现,并最终成为信息时代的动力之一。受限于计算能力,Thurstone 被迫将语言那片丰富多样的景观压扁成问卷作答。在过去 30 年中,自然语言处理经历了多次革命。如果说 Thurstone 发明了一台用来观察语言结构的“望远镜”,那么我们现在手里拿着的就是“哈勃望远镜”。许多新的洞见正等待被发现!