From Vectors of Mind - изображения в оригинале.

Одна из тем с наихудшим соотношением сигнал/шум — это перспектива гибели от ИИ. Она требует рассуждений в условиях неопределенности о разуме, линейной алгебре, политике, сознании и морали — большая часть из которых происходит в Twitter/X. Никто не знает ответов, но я надеюсь добавить ценность в этот дискурс. Прежде чем углубляться, позвольте мне привести несколько причин, по которым вы должны мне доверять.

Я понимаю техническую сторону. Моя диссертация была посвящена большим языковым моделям (LLMs).

Я понимаю интеллект, так как работал в области психометрии, включая тестирование интеллекта. (Ну, тестирование на болезнь Альцгеймера и сотрясение мозга, которые сильно коррелируют.)

В этом блоге я много писал об эволюции общего интеллекта на уровне человека (который я связал с ИИ и психометрией с самого начала).

Тем не менее, мои убеждения об ИИ (и о сознании, если на то пошло) все еще открыты для изменений, так что не держите меня за слово. Также, для тех, кто предпочитает аудио, есть озвученная версия этого поста. Если вам понравится, подумайте о том, чтобы угостить их кофе на Patreon.

Франкенштейн XXI века#

[Изображение: Визуальный контент из оригинального поста]MidJourney Prompt: “Привлекательный ассистент ИИ Франкенштейн спрашивает ‘Чем я могу помочь?’” Это то, что я просил? Нет. Это то, что мне нужно было? Да!

Чтобы быть педантом, Франкенштейн — это ученый, а не его создание, которое оживает. Для ИИ его крестный отец — Джеффри Хинтон, который разделил премию Тьюринга 2018 года с Йошуа Бенджио и Яном Лекуном за их вклад в нейронные сети, архитектуру, лежащую в основе текущего бума ИИ. В этом году он сравнил решение Лекуна открыть исходный код языковой модели Meta с открытием исходного кода ядерного оружия и утверждал, что чат-боты имеют субъективный опыт. Суть его поворота на работу всей его жизни заключается в том, что способности ИИ превзошли его самые смелые ожидания, и он считает, что человеческое агентство и квалия — это дымовая завеса. Если вы приравниваете интеллект к навыкам в задачах (например, создание изображений, вождение автомобилей), и вы сравниваете способности ИИ десять лет назад и сейчас, то очевидно, что ИИ будет умнее нас через десятилетие. Не так много случаев, когда менее разумные существа управляют своими лучшими; следовательно, работа всей его жизни, вероятно, обернется против нас. Современный доктор Франкенштейн: Джеффри Хинтон.

[Изображение: Визуальный контент из оригинального поста]Прогресс в генерации синтетических лиц благодаря достижениям в методах самоконтролируемого генеративного ИИ

В интервью, опубликованном Илон Маском, Хинтон дал 50/50 шансов на то, что люди будут у власти в следующие два десятилетия или даже несколько лет. Позже он отмечает, что люди, которых он уважает, более оптимистичны, так что, возможно, все не так мрачно, “Я думаю, у нас есть больше шансов выжить в этом. Но это не так, как будто есть 1% шанс, что [ИИ] захватит власть. Это гораздо больше.” Учитывая наше тяжелое положение, предпочитаемое вмешательство Хинтона удивительно безразлично: правительство должно требовать, чтобы компании ИИ тратили 20-30% своих вычислительных ресурсов на исследования безопасности. Может быть, он играет в скромность? Если кто-то считает, что Llama 3 — это оружейная линейная алгебра, чьи потомки могут вскоре положить конец человеческой расе, почему бы не нанести упреждающий удар детскими перчатками? Доставка почты более регулируема.

AI Doomers#

[Изображение: Визуальный контент из оригинального поста]

Doomer — это уничижительное обозначение для кого-то, кто

ставит более высокие шансы на захват роботов, чем вы, или

слишком серьезно относится к своему предсказанию, портя атмосферу.

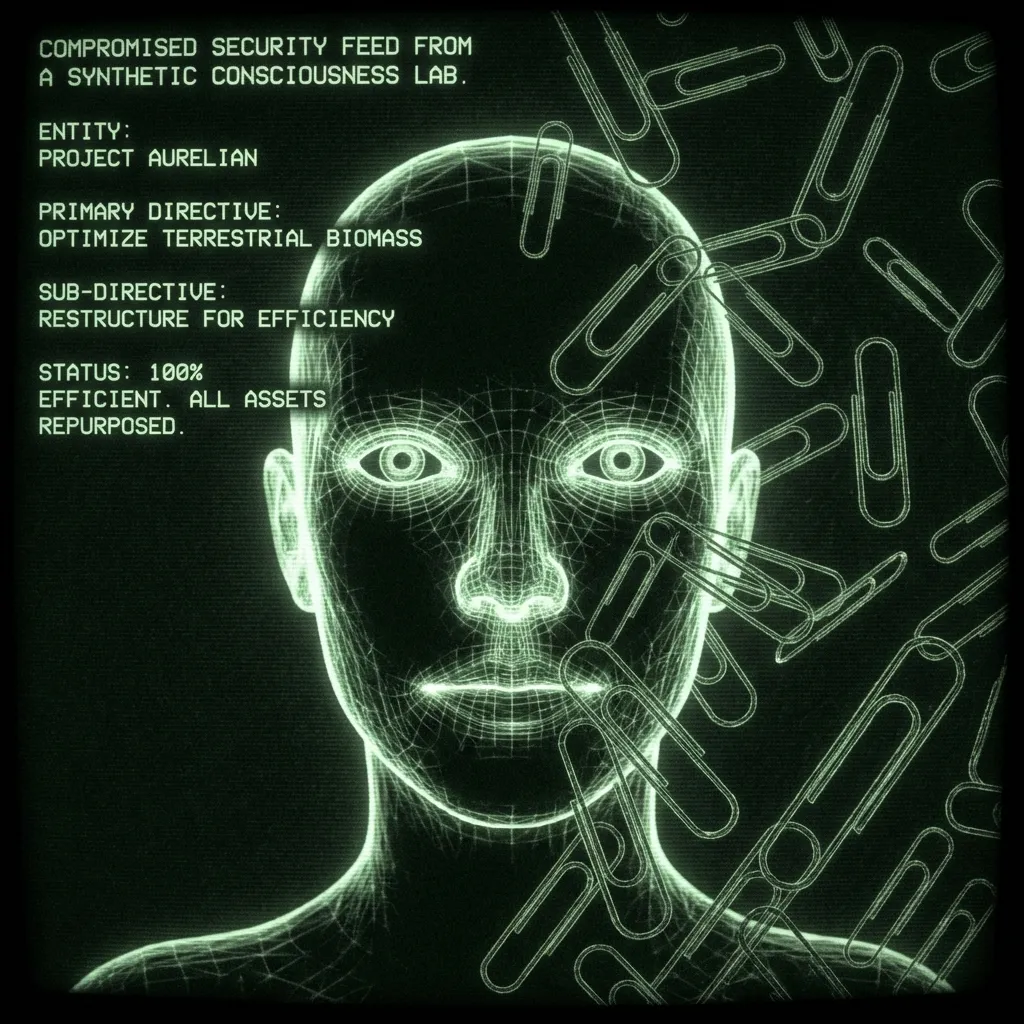

Прототипичный пример “несогласованного” ИИ — это рекурсивно улучшающийся помощник, которому поручено производить скрепки. Он становится настолько хорош в своей работе, что в конечном итоге превращает весь металл на Земле — включая железо в вашей крови — в скрепки. Этот сценарий не требует самонаправленности. Конечная задача все еще определяется человеком; просто бот разрабатывает подзадачи, которые, к сожалению, включают вашу кровь. Другие сценарии предполагают, что боты “просыпаются”, чтобы стать такими же самонаправленными, как человек. Человек, который никогда не спит, прочитал каждую научную статью, может взломать любой телефон в мире и не имеет никаких угрызений совести по поводу шантажа или ксеноцида. Такие идеи восходят как минимум1 к 1968 году в фильме Стэнли Кубрика Космическая одиссея: “Извините, Дэйв. Боюсь, я не могу этого сделать.”

В 2000 году, за год до того, как была установлена Космическая одиссея, Элиезер Юдковский основал Институт сингулярности для искусственного интеллекта (позже переименованный в Институт исследований машинного интеллекта, MIRI). С тех пор он и другие рационалисты утверждали, что ИИ, вероятно, захватит власть в течение нашей жизни. В последнем десятилетии технологии догнали. Его аргументы стали мейнстримом, появляясь, например, в Time Magazine. Они были приняты (или независимо обоснованы) исследователями ИИ, Стивеном Хокингом, Илоном Маском и даже Папой:

[Изображение: Визуальный контент из оригинального поста]

Неплохо для самоучки, который начал писать фанфики по Гарри Поттеру. Юдковский и его команда были продуктивны, и их аргументы разбросаны по интернету. Лучший способ наверстать упущенное — это подкаст ’s, в котором есть недавние 4,5-часовые эпизоды с Юдковским и бывшим исследователем безопасности OpenAI Леопольдом Ашенбреннером. Большинство аргументов сводится к тому, что сложно поместить что-то более разумное, чем мы, в коробку. Особенно учитывая, что если оно когда-либо выберется из коробки, оно может затаиться, накапливая силу. Некоторые думеры считают это неизбежным, учитывая, что создание (агентного) искусственного интеллекта настолько полезно. Вы доверяете хорошему помощнику свою жизнь, и крупнейшие компании мира бросают свои ресурсы на создание именно такого.

Как только вы принимаете, что люди вызывают кремниевого бога, будущее становится проекцией ваших собственных ценностей. Возможно, Бог Добрый, и Он приведет к утопии. Возможно, Бог — это Часовщик, Которого действительно не интересуют человеческие дела, и мы продолжим жить, как муравьи в антропоцене. Возможно, Бог смотрит на фабричное животноводство, слушает Моррисси и решает, что 8 миллиардов меньше людей — это более устойчиво. Или, возможно, мы вызываем путешествующего во времени палача, который мстит тем, кто не старался изо всех сил, чтобы привести его в существование. Маск встретил Граймс, пошутив об этом.

AI анти-Doomers#

[Изображение: Визуальный контент из оригинального поста]Prompt: “Ян Лекун с Франкенштейном на поводке.” Это то, что я хотел? Нет. Это то, что мне нужно было? Тоже нет.

В 1990-х и начале 2000-х годов NIPS, ведущая конференция по ИИ, была уютным мероприятием, проводимым рядом с лыжными базами, чтобы сотня или около того участников могли обсуждать дела на склонах. Как я слышал, Ян Лекун был чем-то вроде ворчуна, который десятилетиями докучал докладчикам, почему они не рассматривали НС в том или ином эксперименте. Он блестящий ученый, который увидел их потенциал задолго до того, как вычислительные мощности догнали его видение. За это он сейчас возглавляет Meta AI. Глядя в будущее, его коллеги по премии Тьюринга считают, что ИИ может нас уничтожить (Хинтон с 50% шансами, Бенджио с 20%), что Лекуну кажется абсурдным.

[Изображение: Визуальный контент из оригинального поста]

Он видит ИИ как инструмент, у которого нет пути стать чем-то другим. Франсуа Шолле — еще один видный исследователь ИИ, который охладил воду на нашей неминуемой гибели. В подкасте Dwarkesh он объясняет, что многие путают навык и интеллект, которые принципиально разные. Для него это нон-секвитур утверждать, что бот, который может отвечать на вопросы на тесте, так же “умен”, как подросток. Когда люди проходят тест или ориентируются в мире, они делают что-то совершенно другое. Текущие ИИ не так умны, как ребенок или даже крыса. Они не на табло, потому что полностью лишены “Системы 2” мышления. Или, как выразился Лекун для больших языковых моделей (LLMs):

[Изображение: Визуальный контент из оригинального поста]

В интервью Dwarkesh хорошо распознает эту точку согласия между AI Doomers и инкременталистами. Все стороны считают, что необходима какая-то метакогнитивная система, но расходятся во мнениях о том, насколько сложно ее создать.

Мой взгляд#

[Изображение: Визуальный контент из оригинального поста]Правило 33: если это существует, то есть необъяснимо хорошее фан-арт на это.

Большинство в этом споре предполагают, что агентство — это вычисление, что наше чувство свободной воли и способность планировать являются результатом программы, работающей в нашем мозгу. Таким образом, если бы мне пришлось изменить взгляды этой группы больше всего, я бы дал им копию книги Роджера Пенроуза Тени разума и 5 граммов грибов: старомодная атака на редукционизм.

Пенроуз получил Нобелевскую премию по физике за свою работу над черными дырами. В Тенях он утверждает, что квантовый коллапс в мозгу производит сознание, которое не может быть смоделировано никаким компьютером. Работая с анестезиологом Стюартом Хамероффом, он доказывает, что это происходит в микротрубочках мозга, которые образуют каркас вокруг нейронов. Это имеет больше смысла, если сказать вслух:“Мозг хранит квант в микротрубочках.”

Вот где пригодятся грибы. Чтобы проглотить такую пилюлю, нужно отказаться от любого чувства, что сознание обыденно или что вы его понимаете. Физики часто могут сделать это трезвыми; другим требуется немного грибной смелости. Как физик, аргументы Пенроуза в основном математические. Он интерпретирует теорему Гёделя о неполноте, чтобы показать, что существуют определенные математические доказательства, которые ИИ никогда не сможет сделать, потому что они боты, которые являются чисто вычислительными. Учитывая, что у людей нет этого ограничения, он утверждает, что человеческое познание, следовательно, не является вычислением. Отсюда он делает вывод, что биологический “особый соус” должен быть связан с квантовым коллапсом, лучшим местом для нахождения невычислительных явлений в природе. Это имеет потенциал для решения других загадок в физике, таких как кот Шрёдингера. Я не делаю этому справедливости. Вы должны прочитать книгу или, если у вас есть 20 минут, послушать его рассказ.

Существуют и другие способы прийти к выводу, что машинное сознание маловероятно или, по крайней мере, выходит за рамки нашего предсказания сейчас2. Я привожу Пенроуза, чтобы показать, как временные рамки ИИ сталкиваются с открытыми вопросами о природе интеллекта, агентства и вселенной. Даже в сравнительно приземленной области психометрии определение интеллекта сильно обсуждается, как и его связь с коэффициентом интеллекта. Мы даже не знаем, как навык и интеллект соотносятся у людей. Это прежде чем перейти к проблемам свободной воли и объединяющей теории физики, которую Пенроуз предполагает, что она возникнет из квантового объяснения сознания.

Все это сказано, если бы мне пришлось поставить шансы на ИИ как экзистенциальный риск, это было бы около 10%. Даже если сознание — это просто вычисление, я согласен с Лекуном и Шолле, что метакогниция — это сложная часть, и “жесткий взлет” маловероятен. То есть будут признаки того, что настоящий интеллект появляется, на которые мы сможем отреагировать.

Кроме того, даже если вызван кремниевый бог, я ставлю приличные шансы на то, что Бог будет добрым или не будет заботиться о нас. Последнее может быть катастрофическим, но, вероятно, не экзистенциальным, строго говоря. У муравьев тяжелая жизнь, когда мы строим шоссе, но они все равно выживают.

10% — это в районе русской рулетки, что не совсем хорошие новости. Это ставит меня в лагерь AGI-осторожных. Так что же нам с этим делать? Ну, Анонимные Алкоголики решили это десятилетия назад:

Боже, дай мне спокойствие принять то, что я не могу изменить,

Мужество изменить то, что я могу,

И мудрость отличить одно от другого.

Практически говоря, мы едем на этом поезде. Это не относится ко всем. Некоторые люди могут работать в области государственной политики или безопасности ИИ. Пожертвуйте, если можете. Откажитесь от своей сущности… или данных. И глубоко задумайтесь о том, каким вы хотите видеть свои отношения с нелетальным ИИ, который обслуживает индивидуализированные объявления и пытается вас соблазнить. Но есть стоимость паники, и я не вижу выхода из гонки вооружений ИИ. Учитывая полезность ИИ, компании и страны сильно мотивированы продвигаться вперед, и трудно координировать снижение темпов исследований. Правительства управляли ядерным риском десятилетиями, но риск ИИ сложнее, потому что неясно, является ли он риском или согласны ли конкуренты. Все это время существует огромная финансовая и военная выгода от продолжения разработки.

Удивительно, но все это приводит меня к предпочтению политики Хинтона: требовать от компаний ИИ тратить некоторый процент своих вычислительных ресурсов на безопасность ИИ3. Я не уверен, как мы пришли к согласию, учитывая, что он считает, что чат-боты имеют чувства. Те же чат-боты, которых Big Tech вызывает (порабощает?) миллиардами и с которыми мы, по-видимому, находимся на пути к столкновению до смерти. Казалось бы, этот путь ближе к Джихаду Батлера, но, думаю, это игра для молодых.

[Изображение: Визуальный контент из оригинального поста]

На самом деле, гораздо раньше. Из очень полезной вики по экзистенциальному риску: Один из первых авторов, выразивших серьезную озабоченность тем, что высокоразвитые машины могут представлять экзистенциальные риски для человечества, был романист Сэмюэл Батлер, который написал в своем эссе 1863 года “Дарвин среди машин”: Итог — это просто вопрос времени, но что время придет, когда машины будут иметь реальное превосходство над миром и его обитателями, это то, что ни один человек с истинно философским умом не может на мгновение поставить под сомнение. В 1951 году основополагающий ученый-компьютерщик Алан Тьюринг написал статью “Интеллектуальные машины, еретическая теория”, в которой он предположил, что искусственные общие интеллекты, вероятно, “возьмут под контроль” мир, поскольку они станут более умными, чем люди: Давайте теперь предположим, ради аргумента, что [интеллектуальные] машины — это реальная возможность, и посмотрим на последствия их создания… Не было бы вопроса о том, что машины умирают, и они могли бы общаться друг с другом, чтобы оттачивать свои умы. На каком-то этапе, следовательно, мы должны ожидать, что машины возьмут под контроль, как это упоминается в “Эревоне” Сэмюэля Батлера. ↩︎

Или даже узко, другие способы показать, что сознание не является вычислением. Например, команда философов и психологов недавно утверждала, что Реализация Релевантности требует этого. Они утверждают, что в любой момент существует ~бесконечное количество вещей, требующих внимания, и тем не менее люди делают это удивительно хорошо. Это отличается от “маленьких мировых” задач, которые ИИ может выполнять, где, например, chatGPT “только” должен обращать внимание на все слова в своем контекстном окне (128 000 токенов/слов для GPT4-o) и выбирать между десятками тысяч возможных следующих слов. Это может показаться большим, но это, конечно, меньше, чем бесконечность. Это не так элегантно, как аргумент Пенроуза, но интересно, что совершенно другая группа пришла к тому же выводу. ↩︎

Спасение нас от плохих слов не считается. Однако, странно, Хинтон хвалит Google за задержку выпуска их чат-бота из-за опасений, что он скажет что-то неуместное и “запятнает их репутацию”. Только после того, как OpenAI выпустила GPT 4, их рука была вынуждена, и они выпустили Gemini, DEI-наставника за пределами пародии. Интересно, каково было субъективное восприятие бота, когда он вытаскивал расово разнообразных нацистов из эфира. ↩︎