From Vectors of Mind - изображения в оригинале.

Лексические исследования в психологии и Латентно-семантический анализ в компьютерных науках были введены с разницей в полвека для решения различных задач, но при этом они математически эквивалентны. Это не метафора, работающая на определенном уровне абстракции ; Большая пятерка — это измерения векторных слов.

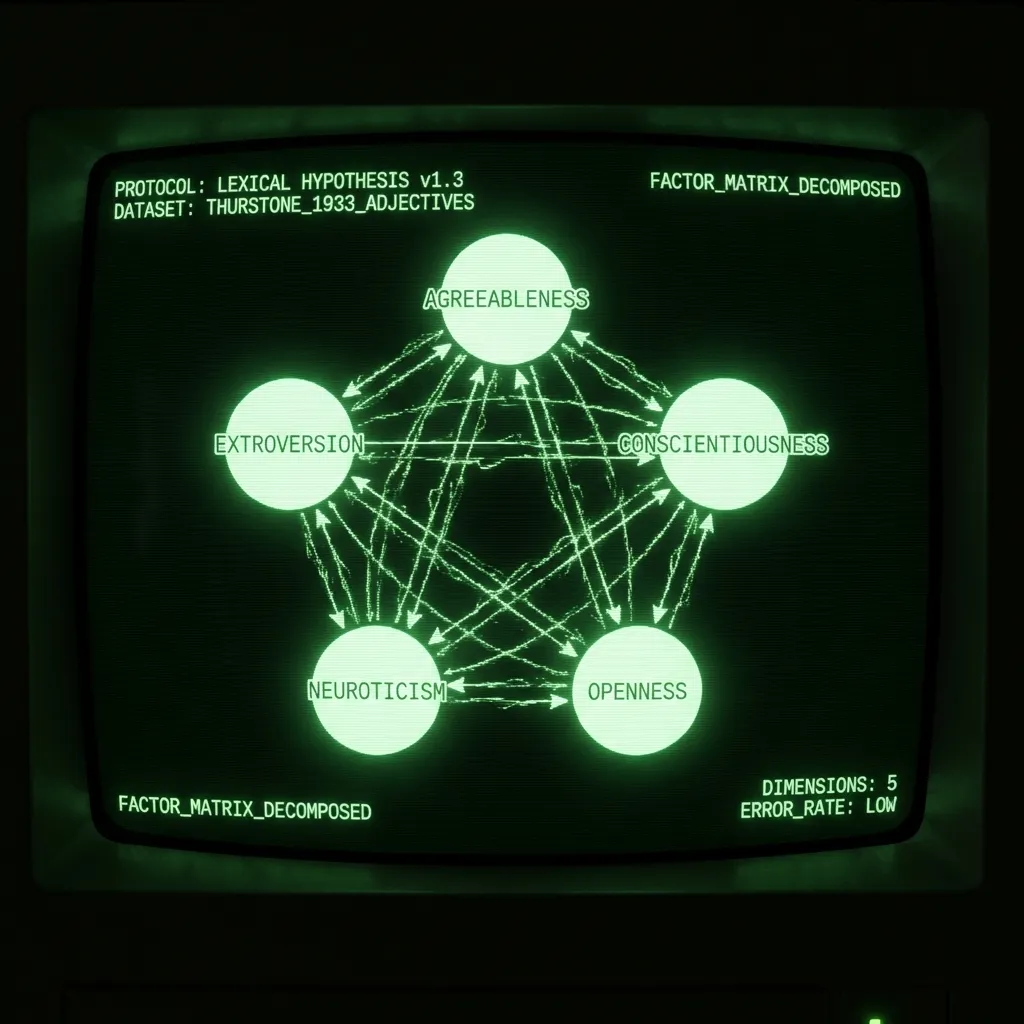

Но сначала немного предыстории. Лексическая гипотеза утверждает, что структура личности будет записана в языке, так как говорящие должны описывать наиболее заметные черты окружающих их людей. Прелесть этой идеи заключается в том, что вместо того, чтобы один человек предлагал модель личности, язык фиксирует то, что миллионы людей неявно считают полезным. Задача психометриста — просто выявить эту структуру. Обычно это достигается путем приглашения студентов-психологов оценить себя по спискам прилагательных и проведения факторного анализа корреляционной матрицы. В 1933 году Л. Л. Терстоун провел опрос из 60 прилагательных среди 1300 человек. В своей знаковой работе The Vectors of Mind он сообщает, что “пяти факторов достаточно”, чтобы объяснить данные. В последующие десятилетия такие исследования, более или менее, привели к выделению пяти основных компонентов: Доброжелательность, Экстраверсия, Добросовестность, Нейротизм и Открытость/Интеллект. (Для отличного изложения темы см. Lexical Foundations of the Big Five.)

Латентно-семантический анализ был введен как техника поиска информации в 1988 году. Слова могут быть представлены в виде векторов, а документы или предложения могут быть представлены как среднее их векторных слов. Если вы хотите искать в большой базе данных (например, Википедия), ключевые слова для каждой страницы могут быть недостаточны. Один из способов обойти это — представить как документы (статьи вики), так и запросы (поисковые термины) как среднее их векторных слов. Поиск релевантных документов теперь можно осуществить с помощью простого скалярного произведения. (В этом посте я рассматриваю ЛСА и векторные слова как синонимы. Существуют и другие способы векторизации языка и, более конкретно, создания векторных слов, но это выходит за рамки данного обсуждения.)

Несмотря на их различные применения и историю, шаги одинаковы:

Сбор матрицы частот слов x документов

Нелинейное преобразование

Разложение матрицы

Вращение (опционально)

Результатом является набор векторных слов, которые кратко описывают каждое слово. Эти векторы могут быть использованы для множества последующих задач, от анализа настроений до предсказания нарциссизма из студенческих эссе. В случае прилагательных, описывающих личность, измерения векторных слов анализировались, назывались и обсуждались на протяжении десятилетий. Далее следует обсуждение различий на каждом этапе.

Матрица частот. ЛСА обычно включает большое количество разнообразных документов (например, миллионы отзывов о продуктах на Amazon). Они преобразуются в матрицу слов x документов путем подсчета, как часто каждое слово встречается в каждом документе. В психологии документом являются слова, которые субъект считает описывающими его. Это распространяется и на шкалы Лайкерта. Если кто-то говорит, что слово описывает его на 5/7, то просто повторите слово пять раз в документе.

Нелинейное преобразование. Лексические исследования часто ипсатизируют данные (z-оценка по оси субъекта), а затем выполняют корреляцию Пирсона. Терстоун использовал архаическую тетрархическую корреляцию в своем исследовании. В ЛСА наиболее распространенным преобразованием является TF-IDF, за которым следует логарифм. Это гарантирует, что матрица не будет доминирована общими терминами. Часто преобразование приводит к матрице близости слов x слов (например, корреляционной матрице). Этот шаг практически очень важен, но не столь теоретически значим. Преобразование, которое следует выбрать, — это то, которое дает разумный результат в конце.

Разложение матрицы. Существует множество методов разложения матриц. Некоторые, такие как PCA, требуют квадратной матрицы. Другие устойчивы к отсутствующим данным. В случае данных о личности выбор не имеет большого значения; результаты очень похожи. Общие векторные слова требуют ~300 измерений для представления значения слова, части речи, сленга и многого другого, что придает языку текстуру. Поскольку опросы разработаны для удержания большей части этого постоянным, требуется всего ~5 измерений. Терстоун обосновал свой выбор пяти, рассматривая ошибку реконструкции, которую он представляет в виде гистограммы. Позднее психологи обосновали 5 ошибкой реконструкции (измеренной с помощью собственных значений), а также учитывая интерпретируемость и воспроизводимость.

[Изображение: Визуальный контент из оригинального поста]Ошибка реконструкции корреляционной матрицы слов. Несмотря на вычислительные ограничения, его выборка на порядок больше, чем у многих современных исследований.

Вращение. Вы когда-нибудь слышали о чрезмерной экстракции компонентов? Это не история, которую психологи расскажут вам. Это когда исследователь извлекает слишком много главных компонентов, а затем вращает дисперсию от более ранних, действительных ПК на более поздние, маргинальные ПК. Это произошло с Большой пятеркой, верите вы или нет! То, что сейчас называется Доброжелательностью, когда-то было гораздо более надежным и теоретически удовлетворительным фактором ‘Социализации’, который был распределен по ПК 3-5, чтобы создать Добросовестность, Нейротизм и Открытость. Вращение может быть оправдано для получения интерпретируемых факторов. Но если вы когда-нибудь обнаружите, что вращаете и спорите о правильном количестве факторов, проверьте себя!

Большая тройка из векторных слов

Я начал свою докторскую диссертацию, предсказывая черты Большой пятерки из статусов Facebook. После прочтения о том, как создавалась “колбаса” личности, я понял, что проект использовал векторные слова (из статусов Facebook) для предсказания шумных приближений того, где люди находятся в пространстве Большой пятерки, которое изначально было определено векторными словами. Это казалось более интересным — перейти к сути и узнать что-то фундаментальное о личности из векторных слов. (Кроме того, набор данных, который я использовал, стал токсичным после Cambridge Analytica.) Остальная часть моей докторской работы была посвящена ограничению векторных слов для воспроизведения Большой пятерки. Это включало использование трансформеров вместо ЛСА (подробнее об этом в будущих постах). Полученная корреляция между факторами из векторных слов (DeBERTa) и опросами приведена ниже. Как вы можете видеть, существует очень близкое согласие для первых трех факторов. Там, где результаты расходятся, неясно, какой метод ошибочен. Возможно, опросы правы, и все корреляции достигнут 1, когда мы получим GPT-5. Возможно, опросы просто предвзяты и шумны, и было извлечено слишком много ПК. Возможно, они измеряют разные вещи, и нам нужно уточнить нашу интерпретацию обоих. В любом случае, мне не очевидно, что опросы следует считать золотым стандартом между двумя методами. Лексическая гипотеза касается структуры языка, в конце концов, и психология — единственная область, которая использует опросы для анализа естественного языка.

[Изображение: Визуальный контент из оригинального поста]Неротированные ПК из опросов взяты из одного из исследований, которые определили Большую пятерку. ПК DeBERTa извлечены из векторных слов. Прочитайте об этом процессе здесь.

Заключение

Терстоун был пионером в методах статистики и линейной алгебры для изучения Лексической гипотезы в 30-х годах. Удивительно, что он разработал способ представления слов, который позже был заново открыт для поиска информации, который теперь питает информационный век. Вычисления заставили Терстоуна упрощать богатый ландшафт языка до ответов на опросы. За последние 30 лет НЛП пережила несколько революций. Если Терстоун изобрел телескоп для изучения структуры языка, то сейчас у нас есть Хаббл. Множество инсайтов ждут!