From Vectors of Mind - изображения в оригинале.

Хорошо, давайте немного отвлечемся от темы сознания. У меня на самом деле было много психометрических исследований, которые я планировал, прежде чем был увлечен призывом сознания. Так трудно оторваться.

[Изображение: Визуальный контент из оригинального поста]Улисс и сирены, картина Джона Уильяма Уотерхауса

Я начал этот блог, чтобы исследовать Лексическую гипотезу с точки зрения машинного обучения. Модели личности определяют наиболее обсуждаемые черты в языке, и мы можем измерять это гораздо лучше в эпоху GPT. Модели личности, полученные либо из векторных представлений слов, либо из традиционных опросов, возвращаются к тем же нескольким чертам, особенно к Большой двойке: социальной саморегуляции и динамизму. Чтобы освежить в памяти, ознакомьтесь с Большая пятерка — это векторы слов и Первичный фактор личности.

Большая пятерка была найдена во многих языках независимо, но сравнение между языками всегда качественное. Исследователи проводят опрос прилагательных личности на турецком или немецком, факторизуют его и как бы на глаз определяют, совпадают ли факторы. Эти данные нельзя использовать, чтобы сказать “Экстраверсия смещена на 15 градусов от Добросовестности в немецком по сравнению с английским.” Чтобы быть настолько точным, оба языка должны иметь какую-то общую основу.

Если вы задаете вопросы на нескольких языках, вы можете связать их, 1) найдя двуязычную группу, которая может ответить на обоих языках, или 2) предполагая, что переводы слов 1:1 (например, fun идеально соответствует divertido в испанском). В первом случае существует сильный эффект отбора. Что если двуязычные люди, как правило, лучше образованы? Второе просто не соответствует действительности. На самом деле, причина факторизации языков вместе заключается в понимании того, как структура личности может различаться между ними. Предположение, что слова одинаковы, сводит на нет цель.

Мои исследования показали, что вы можете извлечь структуру личности из языковых моделей на английском. Естественный вопрос заключается в том, как это изменится, если добавить другие языки. С моделями, обученными на десятках языков, это становится довольно легко исследовать. Вы можете сопоставить любое количество языков с одной и той же основой.

Большая двойка, снова#

Я использовал XLM-RoBERTa для оценки сходства между прилагательными личности. Странно, но эта модель является результатом геноцида в Мьянме. Meta находится в незавидном положении, когда им нужно удалять контент в местах, о которых они имеют очень мало представления. Технически это называется проблемой переноса обучения. Они хотели бы обучить классификатор ненавистнической речи на английском (или другом хорошо обеспеченном языке) и затем применить его к другим языкам. В темные времена моделирования языка (2018) это работало очень плохо. Разговорная речь на бирманском для “давайте соберем геев и убьем их” выглядела для их классификаторов как “должно быть меньше радуг”. Это, конечно, прошло мимо их модерации контента. NYT объяснил последствия: Геноцид, подстрекаемый на Facebook, с постами от военных Мьянмы

Ответ Meta заключался в создании языковой модели, которая могла бы лучше сопоставлять любой язык (ну, 100 языков) с векторными представлениями слов в одном общем пространстве. Таким образом, классификатор ненавистнической речи, обученный на английском, может лучше распространяться на другие языки. (Меньше бирманского нужно для его дообучения.) Используя эту модель, я внедрил слова личности на четырех языках: английском, испанском, французском и турецком. Ниже представлены первые два фактора:

[Изображение: Визуальный контент из оригинального поста]

Эти факторы служат для разделения различных языков. Первый фактор отличает турецкий от индоевропейских языков. По второму фактору романские языки находятся рядом (хотя и близки к турецкому).

Это имеет смысл. Модель обучена предсказывать следующее слово в предложении, поэтому естественно включает языковую информацию. Если кто-то говорит на испанском, он не часто переключается на турецкий. Надежда заключается в том, что в векторном пространстве также есть направления, соответствующие информации о личности.

Если языки достаточно независимы, вам нужно как минимум 3 измерения, чтобы разделить 4 языка на свои собственные непересекающиеся группы. Давайте посмотрим на следующие главные компоненты.

[Изображение: Визуальный контент из оригинального поста]

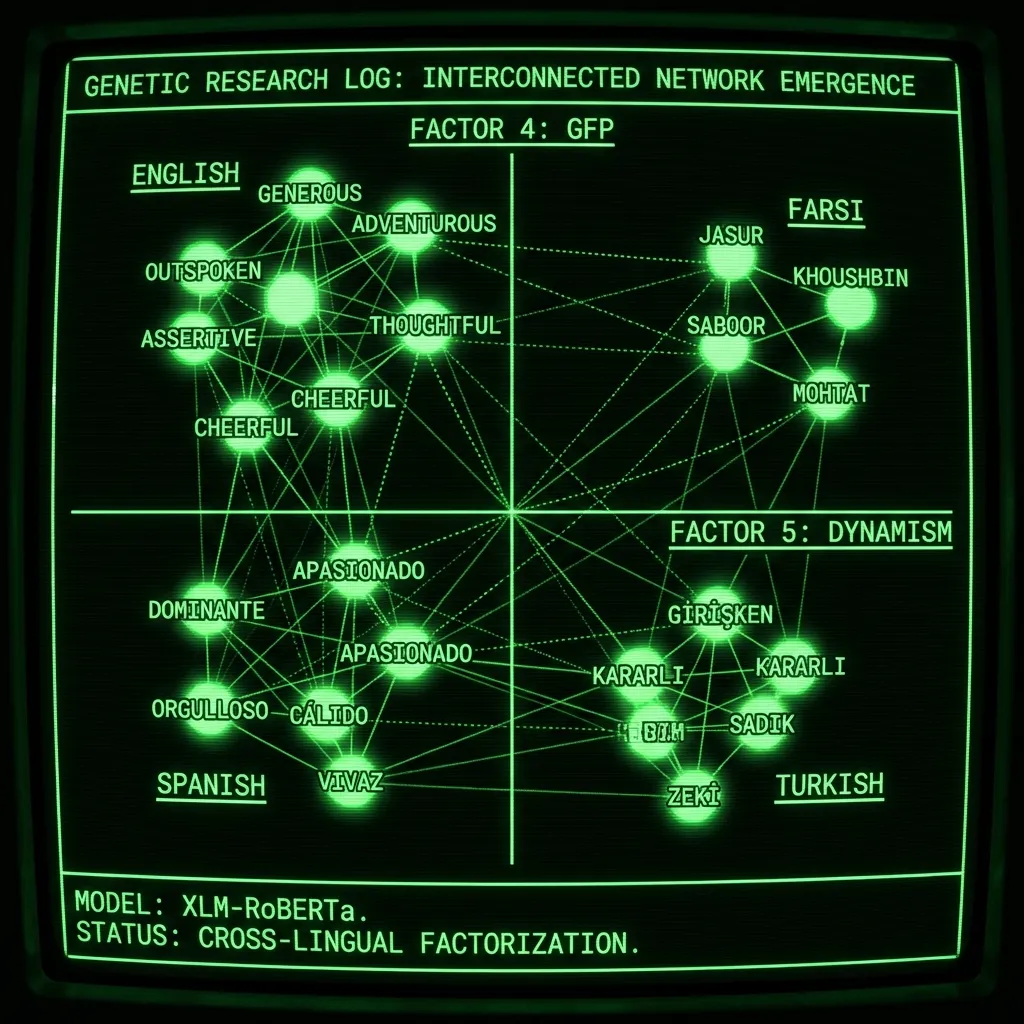

Фактор 4 — это первый фактор, который не был обучен для разделения языков, и это Общий фактор личности! На английском: доминирующий, безжалостный, навязчивый и эгоистичный против щедрый, нежный и внимательный. Я утверждал, что этот фактор лучше всего понимать как склонность жить по Золотому правилу. Теория сознания Евы на самом деле была результатом размышлений о том, что это выбрало бы в нашей эволюционной истории. Фактор 5 также касается личности, давайте изобразим их вместе:

[Изображение: Визуальный контент из оригинального поста]

Мы получаем Большую двойку! Пятый фактор (или второй из факторов личности) — это Динамизм: авантюрный, воображаемый и энтузиастичный против осторожный, сдержанный и трусливый. Удивительно, что это так регулярно проявляется. Существует 2,500 цитирований статьи о Большой двойке, и все же исследователи не осознают, что это просто первые два не вращенных фактора общей личности. Общепринятое мнение, что они каким-то образом существуют в иерархических отношениях с Большой пятеркой, возникло из-за того, что исследователи отказались от непосредственного обращения к языку вскоре после создания инвентаризаций Большой пятерки. С тех пор любая попытка понять базовую или общую личность должна была быть сделана в отношении Большой пятерки. Но сначала были слова, и языковые модели теперь позволяют легко анализировать язык на этом фундаментальном уровне.

Мы должны идти глубже#

Добавление русского и фарси дает те же факторы:

[Изображение: Визуальный контент из оригинального поста]Чтобы лучше увидеть слова, скачайте изображение и увеличьте его.

По моим ленивым инженерным стандартам это довольно трудоемко, потому что требует нахождения хорошего запроса для каждого языка. Я работал с Google Translate и носителями языка, чтобы сделать это правильно, и вы можете видеть, что распределение фарси все еще отклонено по Фактору 4. Моя догадка заключается в том, что мой метод игнорирования любого фактора, который не является общим, слишком груб для такого количества языков. Фактор 4, вероятно, используется как GFP, а также для разделения фарси (немного). Ничто не удерживает эти факторы чистыми, нам действительно повезло, что распределение ведет себя так хорошо. Некоторая предварительная обработка (например, обнуление каждого языкового кластера) может решить эту проблему.

Насколько мне известно, это первый раз, когда несколько языков были факторизованы вместе. Это было бы опубликовано с результатами только на английском и испанском, и здесь я дошел до шести, включая два неиндоевропейских языка. Это также проливает свет на природу Большой двойки, одной из самых популярных и неправильно понятых конструкций в психометрии.

Недостатки#

Я провел это исследование, возможно, самым глупым способом. Я нашел 100 слов личности в руководстве ESL и затем перевел их на другие языки с помощью Google Translate. Если были дубликаты, я удалял их. Это не так плохо, как кажется. Первые два фактора практически не изменяются на английском, независимо от того, используете ли вы 100 или 500 слов. Но если бы это была настоящая статья, вы, очевидно, захотели бы разработать набор слов в каждом словаре независимо. Существует несколько других недостатков:

Недостаточно языков! Если бы я опубликовал это, я бы хотел добавить дюжину языков, которые обычно не изучаются в науке о личности. Это, собственно, и есть причина, по которой я так и не дошел до публикации. Это много работы и потребовало бы носителей нескольких азиатских языков.

Многоязычные модели искажены обучающими данными. Языковые модели обучаются предсказывать следующее слово в предложении. Если вы обучаете с несколькими языками, модель попытается перенести часть знаний. Однако для меньших языков это может выглядеть больше как их значения, принуждаемые к аналогиям в рамках более обеспеченных языков (английский, китайский, русский и т.д.).

Запросы — это степень свободы исследователя. Метод, который я использую для внедрения слов, — это “Моя личность может быть описана как

Устаревшая языковая модель. Я провел эту работу более 2 лет назад, задолго до выхода GPT-4. Более простые времена.

Заключение#

Если бы я все еще был в академической среде, это была бы моя исследовательская повестка. Добавить как можно больше языков и попытаться понять все способы, которыми метод может быть предвзятым. В конце концов, это может привести к созданию универсальной модели личности, превосходящей Большую пятерку. Это помогло бы нам лучше понять, кто мы есть, и, возможно, даже откуда мы пришли. Ведь именно язык сейчас определяет наш вид, и именно язык сформировал нашу психику в глубокой древности. Мы привычно социальны, потому что тысячи лет назад неспособность управлять своей репутацией означала смерть. Модели личности — это карты языка; они являются векторами в эволюции нашего разума.