From Vectors of Mind - images at original.

心理学における語彙研究とコンピュータサイエンスにおける潜在意味解析(Latent Semantic Analysis)は、異なる問題を解決するために半世紀の間隔を置いて導入されましたが、数学的には同等です。これはある抽象レベルで機能する比喩ではありません。ビッグファイブは単語ベクトルの次元です。

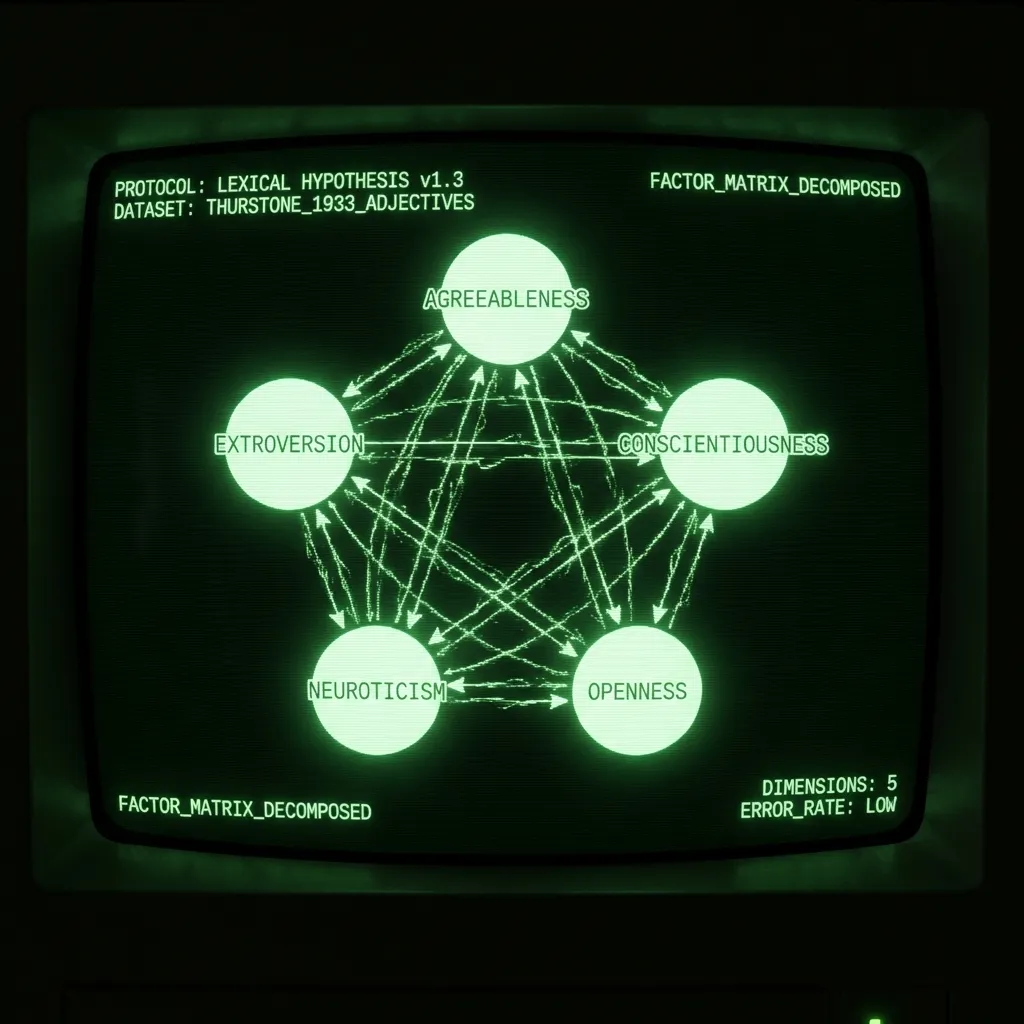

まず、背景を説明します。語彙仮説は、話者が周囲の最も顕著な属性を説明する必要があるため、性格構造が言語に書き込まれると主張します。このアイデアの美しさは、単一の人が性格モデルを提案する代わりに、言語が何百万人もの人々が暗黙的に有用であると合意するものを記録することです。心理測定者の仕事は、この構造を特定することだけです。これは通常、心理学の学生に形容詞のリストを自己評価させ、相関行列に因子分析を行うことで達成されます。1933年に、LL Thurstoneは1300人に60の形容詞の調査を実施しました。彼の重要な著作The Vectors of Mindでは、「データを説明するには5つの因子で十分である」と報告しています。その後の数十年にわたり、このような研究は多かれ少なかれ5つの主要な構成要素をもたらしました:協調性、外向性、誠実性、神経症傾向、開放性/知性。(このテーマについての優れた論文は、Lexical Foundations of the Big Fiveを参照してください。)

潜在意味解析は、1988年に情報検索技術として導入されました。単語はベクトルとして表現され、文書や文はその単語ベクトルの平均として表現されます。大規模なデータベース(例:Wikipedia)を検索したい場合、各ページのキーワードだけでは限界があります。この問題を解決する一つの方法は、文書(ウィキ記事)とクエリ(検索用語)を単語ベクトルの平均として表現することです。関連する文書を見つけることは、単純なドット積で達成できます。(この投稿では、LSAと単語ベクトルを同義として扱います。言語をベクトル化し、特に単語ベクトルを作成する他の方法もありますが、それは今のところ範囲外です。)

異なる用途と歴史にもかかわらず、手順は同じです:

単語 x 文書のカウント行列を収集する

非線形変換

行列分解

回転(オプション)

結果は、各単語を簡潔に説明する単語ベクトルのセットです。これらは、感情分析から学生のエッセイからの自己愛予測まで、多くの下流タスクに使用できます。性格形容詞の場合、単語ベクトルの次元は何十年にもわたって分析され、命名され、議論されてきました。以下は各ステップの違いについての議論です。

カウント行列。 LSAは通常、多数の多様な文書(例:数百万のAmazon製品レビュー)を含みます。これらは、各単語が各文書にどのくらい頻繁に現れるかをカウントすることで単語 x 文書行列に変換されます。心理学では、文書は被験者が自分を説明するために同意した単語です。これはリッカート尺度にも拡張されます。誰かがある単語が自分を5/7で説明すると言った場合、その単語を文書内で5回繰り返すだけです。

非線形変換。 語彙研究では、データをイプサタイズ(被験者軸に沿ってzスコア化)し、その後ピアソン相関を行うことがよくあります。Thurstoneは彼の研究で古風な四分相関を使用しました。LSAでは、最も一般的な変換はTF-IDFであり、その後に対数が続きます。これにより、行列が一般的な用語によって支配されないようにします。しばしば、変換は単語 x 単語の親和性行列(例:相関行列)をもたらします。このステップは実際には非常に重要ですが、理論的にはそれほどではありません。最終的に合理的な結果をもたらす変換を選ぶことが重要です。

行列分解。 行列分解には多くの方法があります。PCAのようなものは正方行列を必要とします。他のものは欠損データに対しても頑健です。性格データでは、選択はあまり重要ではありません。結果は非常に似ています。一般的な単語ベクトルは、単語の意味、品詞、スラング性、言語に質感を与える多くの要素を表現するために約300次元を必要とします。調査はそれらの多くを一定に保つように設計されているため、約5次元のみが必要です。Thurstoneは、彼がヒストグラムとして報告する再構成誤差を見て、5を選んだ理由を正当化しました。後の心理学者は、再構成誤差(固有値で測定)や解釈可能性、再現性を考慮して5を正当化しました。

[Image: Visual content from original post]単語相関行列の再構成誤差。計算上の制約にもかかわらず、彼のサンプルは多くの現代の研究よりも桁違いに大きいです。

回転。 コンポーネントの過剰抽出を聞いたことがありますか?それは心理学者があなたに話す話ではありません。それは研究者があまりにも多くの主成分を抽出し、その後、初期の有効なPCから後の限界的なPCに分散を回転させるときのことです。信じられないかもしれませんが、これがビッグファイブで起こったことです!現在の協調性は、かつてははるかに堅牢で理論的に満足のいく「社会化」因子であり、PC3-5に広がって誠実性、神経症傾向、開放性を作り出しました。回転は解釈可能な因子を生成するために正当化されることがあります。しかし、もしあなたが回転して正しい因子の数について議論している自分を見つけたら、自分をチェックしてください!

単語ベクトルからのビッグスリー

私はFacebookのステータスからビッグファイブ特性を予測する博士課程を始めました。性格のソーセージがどのように作られるかを読んだ後、プロジェクトは単語ベクトル(Facebookのステータス)を使用して、ビッグファイブ空間における個人の位置のノイズの多い近似を予測していることに気づきました。これはもともと単語ベクトルによって定義されていました。単語ベクトルから性格について何か基本的なことを学ぶことがより興味深いように思えました。(また、私が使用していたデータセットはCambridge Analyticaの後に有害になりました。)私の博士課程の残りは、ビッグファイブを再現するために単語ベクトルを制約する作業でした。これはLSAではなくトランスフォーマーを使用することを含みました(詳細は今後の投稿で)。単語ベクトル(DeBERTa)と調査からの因子の相関は以下の通りです。ご覧の通り、最初の3つの因子について非常に近い一致があります。結果が異なる場合、どちらの方法が誤っているのかは明らかではありません。もしかしたら調査が正しく、GPT-5を手に入れたときにすべての相関が1になるかもしれません。もしかしたら調査は偏っていてノイズが多く、あまりにも多くのPCが抽出されたのかもしれません。もしかしたら異なるものを測定していて、両方の解釈を洗練する必要があるのかもしれません。いずれにせよ、調査が2つの間でゴールドスタンダードと見なされるべきであるとは私には明らかではありません。語彙仮説は言語構造についてのものであり、心理学は自然言語を分析するために調査を使用する唯一の分野です。

[Image: Visual content from original post]未回転の調査PCは、ビッグファイブを定義した研究の一つからのものです。DeBERTa PCは単語ベクトルから抽出されています。そのプロセスについてはこちらをお読みください。

結論

Thurstoneは30年代に語彙仮説を探るための統計と線形代数の方法を開拓しました。彼が情報検索のために後に再発見された単語を表現する方法を開発したことは注目に値します。計算はThurstoneに言語の豊かな風景を調査回答に平坦化させました。過去30年間でNLPは複数の革命を経験しました。Thurstoneが言語構造を観察するための望遠鏡を発明したとすれば、今や私たちはハッブルを持っています。多くの洞察が待っています!