From Vectors of Mind - images at original.

L’un des sujets avec le pire rapport signal-bruit est la perspective de la fin du monde causée par l’IA. Cela nécessite de raisonner dans l’incertitude concernant l’intelligence, l’algèbre linéaire, la politique, la conscience et la moralité—la plupart de ces discussions ayant lieu sur Twitter/X. Personne ne connaît les réponses, mais j’espère apporter une certaine valeur au discours. Avant de commencer, permettez-moi de vous donner quelques raisons de me faire confiance.

Je comprends le côté technique. Ma thèse portait sur les modèles de langage de grande taille (LLM).

Je comprends l’intelligence, ayant travaillé dans le domaine de la psychométrie, y compris les tests d’intelligence. (Eh bien, les tests pour Alzheimer et les commotions cérébrales, qui sont fortement corrélés.)

Sur ce blog, j’ai écrit abondamment sur l’évolution de l’intelligence générale au niveau humain (que j’ai liée à l’IA et à la psychométrie depuis le début).

Cela dit, mes croyances sur l’IA (et la conscience, d’ailleurs) sont encore assez ouvertes au changement, donc ne me tenez pas rigueur de ce que je dis ici. De plus, pour ceux qui préfèrent l’audio, a narré cet article. Si vous l’appréciez, envisagez de leur offrir un café sur Patreon.

Frankenstein du 21e siècle#

[Image: Visual content from original post]MidJourney Prompt: “Assistant IA Frankenstein attrayant demande ‘Comment puis-je vous aider?’” Était-ce ce que j’avais demandé? Non. Était-ce ce dont j’avais besoin? Oui!

Pour être pédant, Frankenstein est le scientifique, pas sa création qui prend vie. Pour l’IA, son parrain est Geoffrey Hinton, qui a partagé le prix Turing 2018 avec Yoshua Bengio et Yann LeCun pour leurs contributions aux réseaux neuronaux, l’architecture sous-tendant l’actuelle explosion de l’IA. Cette année, il a comparé la décision de LeCun de rendre open-source le modèle de langage de Meta à celle de rendre open-source les armes nucléaires et a soutenu que les chatbots ont une expérience subjective. Le cœur du revirement sur son œuvre de vie est que les capacités de l’IA ont dépassé son imagination la plus folle, et il croit que l’agence humaine et les qualia sont un écran de fumée. Si vous assimilez l’intelligence à des compétences sur des tâches (par exemple, générer des images, conduire des voitures), et que vous comparez les capacités de l’IA d’il y a dix ans à aujourd’hui, alors il est clair que l’IA sera plus intelligente que nous dans une décennie. Il n’y a pas beaucoup de cas où des entités moins intelligentes gouvernent leurs supérieurs; ergo, son œuvre de vie se retournera probablement contre nous. Le Dr Frankenstein moderne : Geoffrey Hinton.

[Image: Visual content from original post]Progrès dans la génération de visages synthétiques grâce aux avancées des méthodes d’IA générative auto-supervisée

Dans une interview tweetée par Elon Musk, Hinton a donné une probabilité de 50/50 quant à savoir si les humains seraient aux commandes dans les deux prochaines décennies ou même dans quelques années. Plus tard, il note que des personnes qu’il respecte sont plus optimistes, donc cela pourrait ne pas être si sombre, “Je pense que nous avons plus de chances de survivre à cela. Mais ce n’est pas comme s’il y avait 1% de chances que [l’IA] prenne le contrôle. C’est bien plus que cela.” Étant donné notre situation désespérée, l’intervention préférée de Hinton est étonnamment blasée : le gouvernement devrait exiger que les entreprises d’IA consacrent 20 à 30 % de leurs ressources de calcul à la recherche sur la sécurité. Peut-être joue-t-il la carte de la prudence? Si l’on croit que Llama 3 est de l’algèbre linéaire de qualité militaire dont la progéniture pourrait bientôt mettre fin à la race humaine, pourquoi frapper préventivement avec des gants de velours? La livraison du courrier est plus réglementée.

Les pessimistes de l’IA#

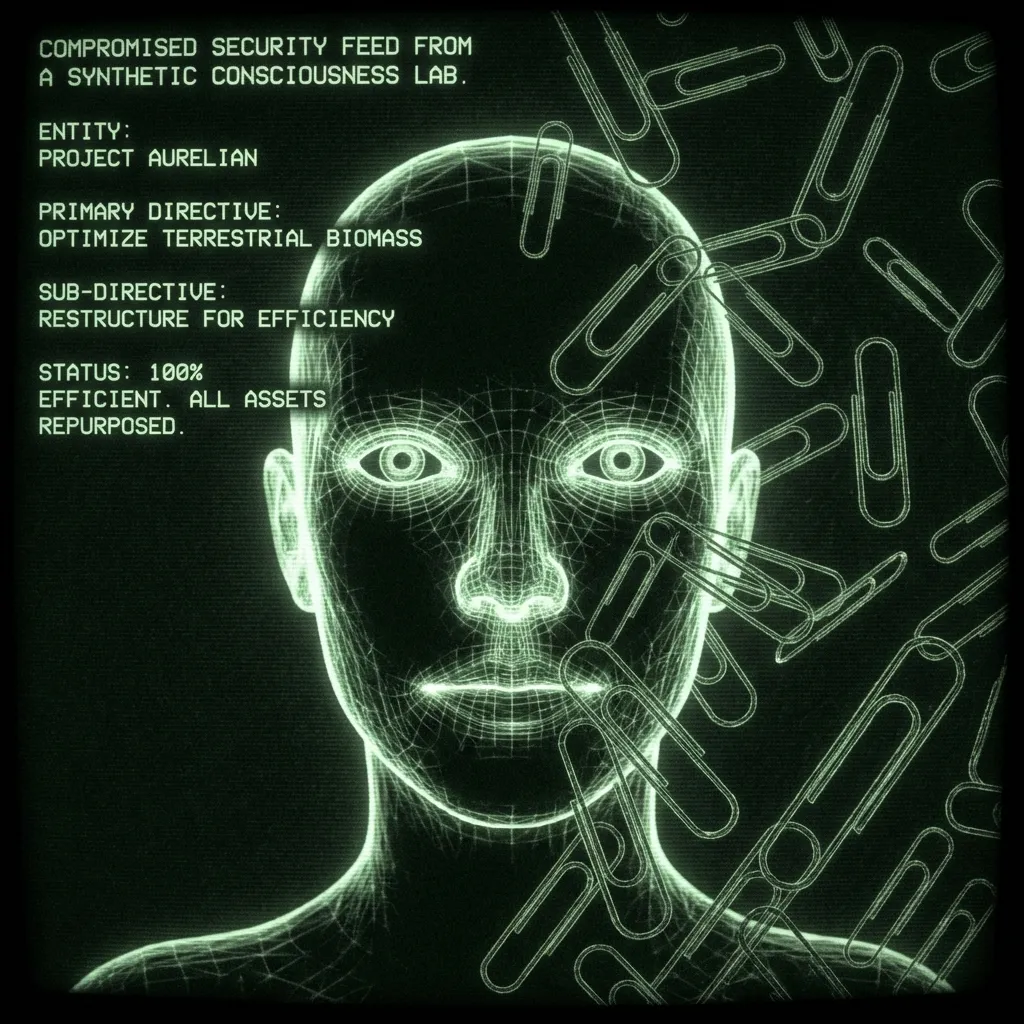

[Image: Visual content from original post]

Le terme “pessimiste” est péjoratif pour quelqu’un qui

attribue une probabilité plus élevée que vous à la prise de contrôle par les robots, ou

prend sa prédiction trop au sérieux, gâchant l’ambiance.

L’exemple prototype d’une IA “non alignée” est un assistant s’améliorant de manière récursive chargé de produire des trombones. Il devient si bon dans son travail qu’il finit par convertir tout le métal sur terre—y compris le fer dans votre sang—en trombones. Ce scénario ne nécessite pas d’auto-direction. La tâche finale est toujours définie par l’humain; c’est juste que le bot développe des sous-tâches qui, malheureusement, impliquent votre sang. D’autres scénarios voient les bots “se réveiller” pour devenir aussi auto-directeurs qu’un humain. Un humain qui ne dort jamais, a lu chaque article scientifique, peut pirater n’importe quel téléphone dans le monde, et n’a aucun scrupule à faire du chantage ou à commettre un génocide. De telles idées remontent au moins1 à 1968 dans 2001, l’Odyssée de l’espace de Stanley Kubrick : “Je suis désolé, Dave. J’ai peur de ne pas pouvoir faire cela.”

En 2000, l’année avant laquelle 2001, l’Odyssée de l’espace était censée se dérouler, Eliezer Yudkowsky a fondé le Singularity Institute for Artificial Intelligence (plus tard renommé Machine Intelligence Research Institute, MIRI). Depuis lors, lui et d’autres Rationalistes ont soutenu que l’IA prendra probablement le contrôle de notre vivant. Au cours de la dernière décennie, la technologie a rattrapé son retard. Ses arguments sont devenus courants, apparaissant, par exemple, dans Time Magazine. Ils ont été adoptés (ou raisonnés indépendamment) par des chercheurs en IA, Stephen Hawking, Elon Musk, et même le Pape:

[Image: Visual content from original post]

Pas mal pour un autodidacte qui a fait ses armes en écrivant des fanfictions de Harry Potter. Yudkowski et son équipe ont été prolifiques, et leurs arguments sont dispersés sur Internet. La meilleure façon de se mettre à jour est le podcast de , qui a récemment diffusé des épisodes de 4,5 heures avec Yudkowsky et l’ancien chercheur en sécurité d’OpenAI Leopold Aschenbrenner. La plupart des arguments se résument à la difficulté de mettre quelque chose de plus intelligent que nous dans une boîte. Surtout si cela sort un jour de la boîte, il peut attendre, accumulant du pouvoir. Certains pessimistes considèrent cela inévitable étant donné que produire une intelligence artificielle (agentique) est si utile. Vous faites confiance à un bon assistant pour votre vie, et les plus grandes entreprises mondiales consacrent leurs ressources à construire exactement cela.

Une fois que vous acceptez que les humains invoquent un dieu de silicium, l’avenir est une projection de vos propres valeurs. Peut-être que Dieu est Bon, et qu’Il inaugurera une utopie. Peut-être que Dieu est un Horloger qui ne peut vraiment pas se soucier des affaires humaines, et nous continuerons à vivre comme les fourmis vivent dans l’Anthropocène. Peut-être que Dieu regarde l’élevage industriel, écoute Morrissey, et décide que 8 milliards d’humains en moins est plus durable. Ou peut-être que nous invoquons un tortionnaire voyageant dans le temps qui inflige des représailles à ceux qui n’ont pas fait de leur mieux pour le faire exister. Musk a rencontré Grimes en plaisantant à ce sujet.

Les anti-pessimistes de l’IA#

[Image: Visual content from original post]Prompt: “Yann LeCun avec Frankenstein en laisse.” Est-ce ce que je voulais? Non. Est-ce ce dont j’avais besoin? Non plus.

Dans les années 1990 et au début des années 2000, NIPS, la conférence d’IA de premier plan, était un événement convivial organisé près des stations de ski pour que la centaine de participants puissent discuter de leurs travaux sur les pistes. Comme je l’ai entendu, Yann LeCun était quelque peu un grincheux qui, pendant des décennies, a harcelé les présentateurs sur la raison pour laquelle ils n’avaient pas envisagé les réseaux neuronaux dans telle ou telle expérience. C’est un brillant scientifique qui a vu leur potentiel bien avant que le calcul ne rattrape sa vision. Pour cela, il dirige maintenant Meta AI. En regardant vers l’avenir, ses compatriotes lauréats du prix Turing pensent que l’IA pourrait nous anéantir (Hinton à 50% de chances, Bengio à 20%), ce qui semble absurde à LeCun.

[Image: Visual content from original post]

Il voit l’IA comme un outil sans chemin pour devenir autre chose. Francois Chollet est un autre chercheur en IA de premier plan qui a refroidi notre extinction imminente. Dans le podcast de Dwarkesh, il explique que beaucoup confondent compétence et intelligence, qui sont fondamentalement différentes. Pour lui, c’est un non-sens de dire qu’un bot qui peut répondre à des questions lors d’un test est aussi “intelligent” qu’un adolescent. Lorsque les humains passent un test ou naviguent dans le monde, ils font quelque chose de complètement différent. Les IA actuelles ne sont pas aussi intelligentes qu’un enfant ou même un rat. Elles ne sont pas sur le tableau de bord car elles manquent complètement de pensée “Système 2”. Ou, comme LeCun l’a dit pour les modèles de langage de grande taille (LLM):

[Image: Visual content from original post]

Dans l’interview, Dwarkesh reconnaît bien ce point d’accord entre les pessimistes de l’IA et les incrémentalistes. Toutes les parties pensent qu’un certain type de système méta-cognitif est nécessaire mais ne s’accordent pas sur la difficulté de le produire.

Mon point de vue#

[Image: Visual content from original post]Règle 33 : si cela existe, il y a inexplicablement de bons fan arts à ce sujet.

La plupart des participants à ce débat supposent que l’agence est un calcul—que notre sens du libre arbitre et notre capacité à planifier sont le résultat d’un programme fonctionnant dans notre cerveau. En tant que tel, si je devais changer le plus les vues de ce groupe, je leur donnerais une copie de Les Ombres de l’Esprit de Roger Penrose et 5 grammes de champignons : une attaque en tenaille à l’ancienne contre le réductionnisme.

Penrose a reçu le prix Nobel de physique pour ses travaux sur les trous noirs. Dans Les Ombres, il soutient que l’effondrement quantique dans le cerveau produit la conscience, qui ne peut être simulée par aucun ordinateur. Travaillant avec l’anesthésiste Stuart Hameroff, il soutient que cela se produit dans les microtubules du cerveau qui forment une charpente autour des neurones. Cela a plus de sens si vous le dites à voix haute :“Le cerveau stocke le quantique dans les microtubules.”

C’est là que les champignons entrent en jeu. Avaler une telle pilule nécessite de renoncer à toute idée que la conscience est banale ou que vous la comprenez. Les physiciens peuvent souvent le faire à jeun; d’autres nécessitent un peu de courage fongique. En tant que physicien, les arguments de Penrose sont principalement mathématiques. Il interprète le théorème d’incomplétude de Gödel pour montrer qu’il existe certaines preuves mathématiques que l’IA ne pourra jamais faire parce qu’elles sont des bots, qui sont purement computationnels. Étant donné que les humains n’ont pas cette limitation, il soutient que la cognition humaine n’est donc pas un calcul. De là, il raisonne que la sauce biologique spéciale doit être liée à l’effondrement quantique, le meilleur endroit pour trouver des phénomènes non computationnels dans la nature. Cela a le potentiel de résoudre d’autres mystères en physique, comme le chat de Schrödinger. Je ne lui rends pas justice. Vous devriez lire le livre ou, avec un budget de 20 minutes, écouter son récit.

Il existe de nombreuses autres façons de conclure que la conscience des machines est peu probable, ou du moins au-delà de notre capacité à prédire pour le moment2. Je mentionne Penrose pour montrer comment les calendriers de l’IA se heurtent à des questions ouvertes sur la nature de l’intelligence, de l’agence et de l’univers. Même dans le domaine comparativement pédestre de la psychométrie, la définition de l’intelligence est très débattue, tout comme sa relation avec le Quotient Intellectuel. Nous ne savons même pas comment compétence et intelligence correspondent chez les humains. Cela avant d’aborder les problèmes du libre arbitre et d’une théorie unificatrice de la physique, que Penrose suggère de découler d’un compte quantique de la conscience.

Tout cela dit, si je devais évaluer les chances que l’IA soit un risque existentiel, ce serait autour de 10%. Même si la conscience n’est qu’un calcul, je suis d’accord avec LeCun et Chollet que la métacognition est la partie délicate, et un “décollage rapide” est peu probable. C’est-à-dire qu’il y aura des signes que la véritable intelligence émerge, auxquels nous pourrons répondre.

De plus, même si un dieu de silicium est invoqué, je mets de bonnes chances que Dieu soit bon ou qu’il ne se soucie pas de nous. Ce dernier pourrait être cataclysmique mais probablement pas existentiel, à proprement parler. Les fourmis ont des difficultés lorsque nous construisons une autoroute, mais elles s’en sortent quand même.

10% est dans le voisinage de la roulette russe, ce qui n’est pas exactement une bonne nouvelle. Cela me place dans le camp prudent face à l’AGI. Alors, que devrions-nous faire à ce sujet? Eh bien, les Alcooliques Anonymes ont résolu cela il y a des décennies :

Dieu, accorde-moi la sérénité d’accepter les choses que je ne peux pas changer,

Courage de changer les choses que je peux,

Et sagesse de connaître la différence.

Pratiquement parlant, nous sommes embarqués pour le voyage. Cela ne vaut pas pour tout le monde. Certaines personnes peuvent travailler dans la politique publique ou la sécurité de l’IA. Faites un don si vous le pouvez. Refusez-leur votre essence… euh, données. Et réfléchissez profondément à la relation que vous souhaitez avoir avec une IA non létale servant des publicités individualisées et essayant de vous séduire. Mais il y a un coût à paniquer, et je ne vois pas de sortie de la course aux armements de l’IA. Étant donné l’utilité de l’IA, les entreprises et les pays sont fortement incités à aller de l’avant, et il est difficile de coordonner un rythme de recherche réduit. Les gouvernements ont géré le risque nucléaire pendant des décennies, mais le risque de l’IA est plus difficile car il n’est pas clair s’il est un risque ou si les concurrents sont d’accord. Tout cela alors qu’il y a un énorme avantage financier et militaire à poursuivre le développement.

Étonnamment, tout cela me conduit à la préférence politique de Hinton : exiger que les entreprises d’IA consacrent un certain pourcentage de leur calcul à la sécurité de l’IA3. Je ne sais pas comment nous avons fini par être d’accord, étant donné qu’il pense que les chatbots ont des sentiments. Les mêmes chatbots que Big Tech invoque (esclavage?) par milliards et avec lesquels nous sommes apparemment en route vers une collision mortelle. Il semblerait que ce chemin soit plus proche du Jihad Butlerien, mais je suppose que c’est un jeu de jeune homme.

[Image: Visual content from original post]

En réalité, bien plus tôt. D’après le très utile Wiki sur le risque existentiel : L’un des premiers auteurs à exprimer une préoccupation sérieuse selon laquelle des machines très avancées pourraient poser des risques existentiels pour l’humanité était le romancier Samuel Butler, qui a écrit dans son essai de 1863 Darwin parmi les machines : Le résultat final est simplement une question de temps, mais que le moment viendra où les machines détiendront la véritable suprématie sur le monde et ses habitants est ce que personne d’une véritable pensée philosophique ne peut un instant remettre en question. En 1951, le scientifique informatique fondateur Alan Turing a écrit l’article “Intelligent Machinery, A Heretical Theory”, dans lequel il a proposé que les intelligences artificielles générales prendraient probablement “le contrôle” du monde à mesure qu’elles deviendraient plus intelligentes que les êtres humains : Supposons maintenant, pour les besoins de l’argumentation, que les machines [intelligentes] sont une possibilité réelle, et examinons les conséquences de leur construction… Il n’y aurait pas de question de la mort des machines, et elles seraient capables de converser entre elles pour aiguiser leur esprit. À un certain stade, nous devrions donc nous attendre à ce que les machines prennent le contrôle, de la manière mentionnée dans Erewhon de Samuel Butler. ↩︎

Ou même de manière étroite, d’autres façons de montrer que la conscience n’est pas un calcul. Par exemple, une équipe de philosophes et de psychologues a récemment soutenu que la Réalisation de la Pertinence nécessite autant. Ils affirment qu’à tout moment, il y a ~un nombre infini de choses qui demandent de l’attention, et pourtant les gens font un travail remarquablement bon. Cela est différent des tâches “petit monde” que l’IA peut accomplir où, par exemple, chatGPT “n’a” qu’à prêter attention à tous les mots dans sa fenêtre de contexte (128 000 tokens/mots pour GPT4-o) et choisir entre des dizaines de milliers de mots possibles suivants. Cela peut sembler beaucoup, mais c’est certainement moins que l’infini. Ce n’est pas aussi élégant que l’argument de Penrose, mais il est intéressant qu’un groupe très différent ait trouvé la même chose. ↩︎

Nous sauver des mauvais mots ne compte pas. Cependant, étrangement, Hinton crédite Google d’avoir retardé la sortie de leur chatbot par crainte qu’il ne dise quelque chose de déplacé et “ternisse leur réputation.” Ce n’est qu’après qu’OpenAI ait produit GPT 4 que leur main a été forcée, et ils ont sorti Gemini, un censeur DEI au-delà de la parodie. On se demande quelle est l’expérience subjective du bot alors qu’il tirait des nazis racialement divers de l’éther. ↩︎